重複コンテンツとは、異なるURLのページにおいて、内容が酷似しているコンテンツのことです。

重複コンテンツの発生は、一つのページにSEO評価や被リンクを集約できなかったり、クローリング(検索エンジンの巡回)に悪影響を及ぼしたりと、さまざまなデメリットがあります。

本記事では、重複コンテンツの定義やSEOに与える影響から、対策方法や改善方法、調べ方まで解説します。

重複コンテンツと混同されやすい「コピーコンテンツ」との違いも解説するので、ぜひ参考にしてください。

この記事でわかること

重複コンテンツとは?基準を解説

重複コンテンツとは、同じような内容のページが、異なるURLで存在するコンテンツのことです。

例えば、まったく同じ文章で商品が紹介されていたり、構成や内容がほとんど同じだったりする場合、検索エンジンから重複コンテンツと見なされます。

また、URLのwwwの有無が異なるページなど、Webサイトのシステムによって生じることも多いです。

実際に生じる重複コンテンツの例を見てみましょう。

- まったく同じ文章が掲載されているページ

- 構成や内容が同じで、部分的に変更しているページ

- wwwあり/ wwwなし/ http / httpsなど、異なるURLをもつページ

- パラメータやセッションIDを付与している動的なURLをもつページ

- PCやスマホ、タブレットなど様々なデバイスに対応するために作られたページ

- Amazonや楽天のようなECサイトにおける、商品のカラーやサイズごとに作られたページ

- noteやはてなブログなどに、自社サイトで作ったページを他サイトに寄稿したページ

上記のような例は意図せず生じることも多いので、適切な対策が必要になります。

重複コンテンツとコピーコンテンツの違い

重複コンテンツとコピーコンテンツは混同されやすいですが、厳密には異なるものです。

コピーコンテンツとは、他サイトやページから無断でコンテンツを盗用して作成したコンテンツを指します。

重複コンテンツが意図せず発生するのに対し、コピーコンテンツは意図的に作成されるものです。

| 重複コンテンツとコピーコンテンツの違い | ||

|---|---|---|

| 項目 | 重複コンテンツ | コピーコンテンツ |

| 定義 | 同じサイト内または異なるURL間で、ほぼ同じ内容が存在するコンテンツ | 他のサイトやページから無断でコピーしたコンテンツ |

| 意図 | 意図せず発生することが多い | 故意に他のサイトのコンテンツを盗用する |

| SEOへの影響 | SEO評価が分散し、検索順位が下がる可能性がある | Googleのスパムポリシーに違反し、ペナルティを受ける可能性がある |

| 主な原因 | サイトの仕様やCMSの設定によるURLの重複、類似ページの作成 | 他のWebサイトのコンテンツをコピー&ペーストして流用する |

| 対処法 | canonicalタグやnoindex、リライトでの差別化など ※詳しくは本ページの後半で解説しています。 |

該当サイトへの削除依頼やGoogleへの申告 |

これは、意図的に他者の文章や情報をコピーし、自サイトのオリジナルコンテンツとして掲載する行為であり、著作権侵害や不正行為に当たることが多いです。

Googleは検索品質を維持するために「スパムに関するポリシー」を公開しており、そのなかでコピーコンテンツについて、「スクレイピング」という項目で取り上げています。

【スクレイピング】

- 他のサイトのコンテンツを、元のソースを引用もせず、独自のコンテンツや価値を加えずに転載する

- 他のサイトのコンテンツをコピーし、(語句を類義語に置き換えたり自動化された手法を使用したりして)若干の修正を加えたうえで転載する

- ユーザーに対してなんらかの形で独自のメリットを提供することなく、他のサイトからのコンテンツ フィードをそのまま掲載する

- ユーザーに実質的な付加価値を提供することなく、他のサイトの動画、画像、その他のメディアなどのコンテンツを埋め込んだり編集したりしているだけのサイトを作成する

引用元:https://developers.google.com/search/docs/essentials/spam-policies?hl=ja#scraped-content

このように、「他サイトのコンテンツを許可なくコピーし、それを独自のものとして掲載する行為」をスパムとみなすとのこと。

スパムと判定されたら、検索順位が大幅に下がるだけでなく、検索結果に表示されなくなる可能性もあります。

SEO対策を進めるときに、上位表示している外部サイトを調査することは重要ですが、外部サイトのコンテンツの書き方や言い回し、内容を意図的にコピーすることはNGということを押さえておきましょう。

さらに、自サイトのコンテンツがコピーされている場合もコピーコンテンツと見なされる可能性があります。このような場合には、該当サイトへの削除依頼やGoogleへの申告をしてください。

コピーコンテンツの発生を避けるには、コピペチェックツールでコピー率を確認することも大切です。

弊社が提供するSEOツール「EmmaTools」は、検索上位を狙えるSEO記事の作成から、コピーコンテンツチェックまでサポートします。

現在、7日間の無料トライアルを実施しているので、ぜひ新規記事作成やリライトにお役立てください。

重複コンテンツが及ぼすSEOへの影響

重複コンテンツはペナルティの対象にはなりませんが、SEO評価低下につながります。

- コンテンツ評価や被リンク評価が分散する

- クローラビリティが悪化する

- UX(ユーザーエクスペリエンス)が低下する

SEOへの影響について、詳しく見ていきましょう。

コンテンツ評価や被リンク評価が分散する

重複コンテンツがあると、Googleからのコンテンツ評価や被リンク評価が分散してしまいます。

そうなると、意図しないページがインデックスされたり、重要なページに対する評価がされなかったりすることも。

また、内容が重複したAとBというページがある場合、外部サイトからの被リンクも、AとBに分散されてしまいます。

評価や被リンクの分散が起きると、結果的にどのコンテンツも評価されず、検索結果に表示されなくなる可能性も生じるため注意が必要です。

クローラビリティが悪化する

重複コンテンツは、Googleのクローラビリティにも悪影響を及ぼします。

検索エンジンは、クローラーと呼ばれるロボットを巡回させ、URLごとに各Webサイトの情報を収集しています。そのため、サイト内に重複コンテンツがある場合、クローラーは同じ情報を何度も繰り返し収集することになってしまうことに。

クローラーは、1サイトでクロールできるページ数の上限(クロールバジェット)があります。重複コンテンツがあることでクロールバジェットを浪費してしまい、本来クロールされるべきページがクローリングされない状態になってしまいます。

クローラビリティが悪化すると、インデックス登録されるまでの時間が長くなったり、検索順位が上がらなかったりしてしまうことも少なくありません。

UX(ユーザーエクスペリエンス)が低下する

重複コンテンツは、ユーザーにとっての不便性や、信頼性の低下につながります。

ユーザー目線で既に読んだ情報を、何度も繰り返し見ることになるためです。

サイトのUX(ユーザーエクスペリエンス)が低下すると、訪問者の満足度が下がり、直帰率の増加や回遊率の低下につながります。

結果的に検索エンジンの評価も悪化し、SEOの観点からも大きなデメリットとなるでしょう。

重複コンテンツの対策・改善方法10選

重複コンテンツには、原因ごとに適切な対策・改善方法があります。

- ページURLの表記ルールを定める

- 301リダイレクトを行う

- canonicalタグを使う

- noindexタグの設置

- レスポンシブデザインに対応する

- ページを削除・または非公開にする

- 無断転載されていたら削除要請をする

- リライトで差別化する

- 定型文の使用を避ける

現時点では重複コンテンツがない場合でも、これから作成するコンテンツが重複しないよう、対策しておきましょう。

301リダイレクトを行う

301リダイレクトとは、自動でほかのURLへ転送されたことを示す設定のこと。

wwwの有無やhttpとhttpsの違いなど、一つのページに対してURLが複数作成されてしまうケースや、掲載している内容が似ていたり、ユーザーの役にあまり立ちそうにないページがあったりする場合、有効な対策方法です。

301リダイレクトを設定して一つのURLに転送されるように設定することで、URLが統一され、重複コンテンツと判断されるリスクを避けられます。

301リダイレクトを設定する際は、管理リストを作って転送元と転送先をどう設定しているか確認できるようにしておきましょう。

canonicalタグを使う

既にサイト内で重複してしまっているコンテンツがある場合は、canonical(カノニカル)タグで対処しましょう。

canonicalタグ(カノニカルタグ)とは、同一サイト内に内容が重複したページや類似するページがある際に、検索エンジンに「どのページを評価してほしいか」を伝えるためのタグのこと。

ECサイトにおける商品のバリエーションページや、デバイスごとに異なるURLページがある場合、canoicalタグで一つのURLへ正規化しましょう。

noindexタグの設置

ユーザーにとって必要な類似コンテンツを残す際は、noindexタグの設置が効果的です。

noindexタグは、検索エンジンに対して特定のページをインデックスしないよう指示するためのメタタグです。

検索エンジンがWebべージを認識する流れは、「クロール(クローリング)」でページの情報を収集し、「インデックス登録(インデクシング)」を経て、「順位付け(ランキング)」となります。

- クロール(クローリング)

- インデックス登録(インデクシング)

- 順位付け(ランキング)

この過程において、「インデックス登録」を拒否するために使用されるのがnoindexタグです。

このタグを設置すると、該当ページが検索エンジンのデータベースに登録されなくなり、検索結果に表示されません。そのため、重複コンテンツとして認識されてしまうページにnoindexタグを設定することで、検索エンジンに存在を認識させないことが可能です。

レスポンシブデザインに対応する

パソコン、スマートフォン、タブレットなど、デバイスごとにURLが生成されることも、重複コンテンツの原因になります。

そのため、異なるデバイスで同じURLのページを適切に表示できるようにする「レスポンシブデザイン」の対応も、対処法として効果的です。

レスポンシブデザインの導入は重複コンテンツの対策だけでなく、サイトの情報を一つのページで管理できるため、更新作業の効率が向上するメリットも。

さらに、Googleはレスポンシブデザインを推奨しており、適切に対応することで検索エンジンの評価が向上しやすくなります。

ページを削除・または非公開にする

重複コンテンツを改善する最終的な手段として、ページの削除や非公開の対応が挙げられます。

コンテンツを作成したものの、ユーザーの検索意図と内容が合わなかったり、今後リライトする予定がなかったりするなら、検討してみましょう。

注意点として、ページを削除する前に、外部サイトからの被リンクや内部リンクが貼られていないかチェックしておきましょう。削除しようとしているページにリンクが貼られているとSEO評価が下がります。

また、ページを削除する場合は、Googleにインデックスされている情報も削除しておきましょう。Google Search Consoleから、該当するページのインデックス情報の削除依頼を行うことができます。

無断転載されていたら削除要請をする

重複コンテンツとは異なりますが、他社にコンテンツの内容や文章を転用されている場合、コピーコンテンツと見なされたり、流入を奪われたりすることがあります。

コピーコンテンツはGoogleからスパムと見なされることもあるので、該当サイトに削除要請をしましょう。

応じてもらえない場合は、Googleに「著作権侵害による削除通知」を送信しましょう。

リライトで差別化する

類似した内容の記事がある場合、リライトによってコンテンツの内容に差別化を図る方法もあります。

SEOにおけるリライトとは、文章の表現を変更するだけでなく、対策キーワードを見直し、ユーザーのニーズに沿った情報を追加することも含みます。

ユーザーにとって価値のある最新の情報を加筆することにより、検索エンジンの評価や、CV数向上が期待できるでしょう。

記事を差別化する例として、「SEO対策」に関するコンテンツがある場合、 「初心者向けに基礎知識を解説するページ」と「上級者向けにSEO対策のトレンドを解説するページ」のように、異なる内容で記事をリライトすれば、自然と差別化が可能です。

したがって、対策キーワードやユーザーニーズを適切に設定し、それぞれに応じた情報を盛り込むことで、重複コンテンツのリスクを回避できます。

弊社では、会員登録不要で記事のスコア・状況チェックができる「コンテンツ無料診断」を提供中です。リライトの参考になる一言アドバイスもあるので、ぜひお役立てください。

定型文の使用を避ける

重複コンテンツの予防方法として、コンテンツを作成する際、自社や自社商材について定型文を作らないように意識しましょう。

ほかのページで使った画像や文章を使いまわしているサイトは多いですが、本来コンテンツごとにユーザーの検索意図や求められている情報は異なるため、適切なコンテンツ作成ではありません。

コンテンツを作成する際は、各ページにアクセスする読者に寄り添った表現を使うようにしましょう。

重複コンテンツの調べ方

ここまで重複コンテンツによるSEOへの影響について解説してきました。

本ページを読んで、自社サイトにどのくらい重複コンテンツがあるのか、気になった方もいるのではないでしょうか。

ここからは、重複コンテンツがあるか調べる方法についてご紹介します。

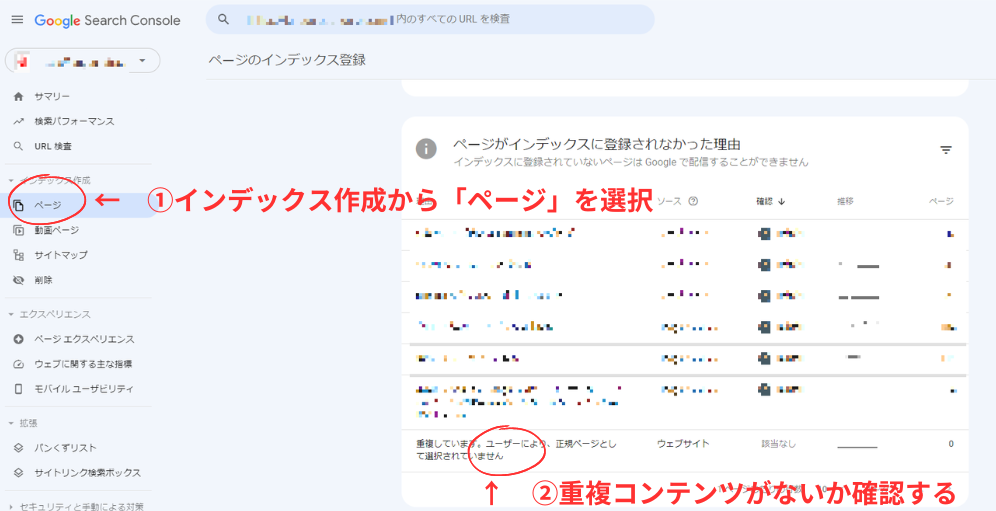

Google Search Console(サーチコンソール)を使って調べる

自社サイト内の重複コンテンツは、Google Search Consoleを使って確認可能です。

調べ方は、サーチコンソールにログインし、メニューの「インデックス作成」から「ページ」を選択します。サイト内に重複しているコンテンツがあれば表示されます。

サーチコンソールは無料で利用できるので、チェックしておきましょう。

重複コンテンツチェックツールを使う

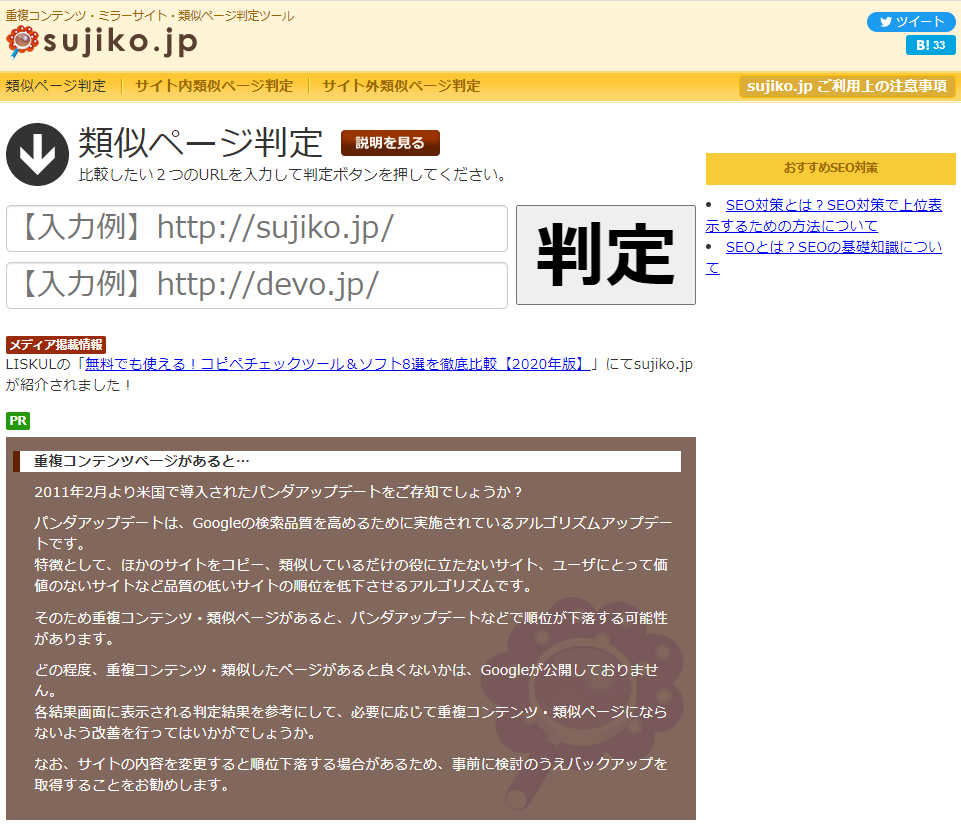

新しいコンテンツを作成し、外部サイトと内容が重複していないか確認したいときには、下記のようなチェックツールを試してみましょう。

sujiko.jp

引用元:http://sujiko.jp/

sujiko.jpは、作成したコンテンツと他社のコンテンツがどれくらい重複しているか確認できる無料ツールです。2つのURLをそれぞれの窓に入力し、判定すると文章や構成(HTML)などの類似点を確認できます。

あらかじめ似ているか心配なページがあった場合のチェックに最適です。ただし、一日の使用上限が5回までとなっているのでご注意ください。

CopyContentDetector

引用元:https://ccd.cloud/

CopyContentDetectorは、作成するコンテンツがその他のサイトと重複していないか、確認できる無料ツールです。

新しいコンテンツに記載するテキストを貼り付け、「規約に同意してコピペチェックする」をクリックします。重複している内容があれば表示されるので、類義語での置き換えなどの対策をしましょう。

EmmaTools

引用元:https://emma.tools/

EmmaToolsは、当社が運営するAI×SEOライティングツールです。

作成したコンテンツに対し、「コピー率チェック」機能を利用することで、Web上に公開されているコンテンツとのコピー率を確認することができます。

また、独自のプロンプトと独自のロジックで、高品質なSEOコンテンツを短時間で作成することが可能です。

現在、7日間の無料トライアルを実施しているので、お気軽にお試しください。

Google検索でコマンドを使って調べる

手軽に重複コンテンツを調べる方法として、Google検索でコマンド「&filter=0」を使う方法があります。

本来のGoogle検索では重複コンテンツが非表示になりますが、「&filter=0」を追加することで、重複コンテンツを表示させることが可能です。

方法は、GoogleでメインKWを検索したあと、検索結果のURLの末尾に「&filter=0」を追加して再検索するだけです。

「&filter=0」を使ったときにだけページが表示される場合、重複コンテンツと見なされている可能性が高いでしょう。

重複コンテンツに関するFAQ

最後に、重複コンテンツに関する疑問に回答していきます。

重複コンテンツに基準はありますか?

「どの程度類似していると重複コンテンツと判断されるのか」の基準について、Googleは明確な基準を公表していません。

そのため、重複コンテンツかどうかはご自身でチェックする必要があります。本ページでご紹介した調べ方にて確認しましょう。

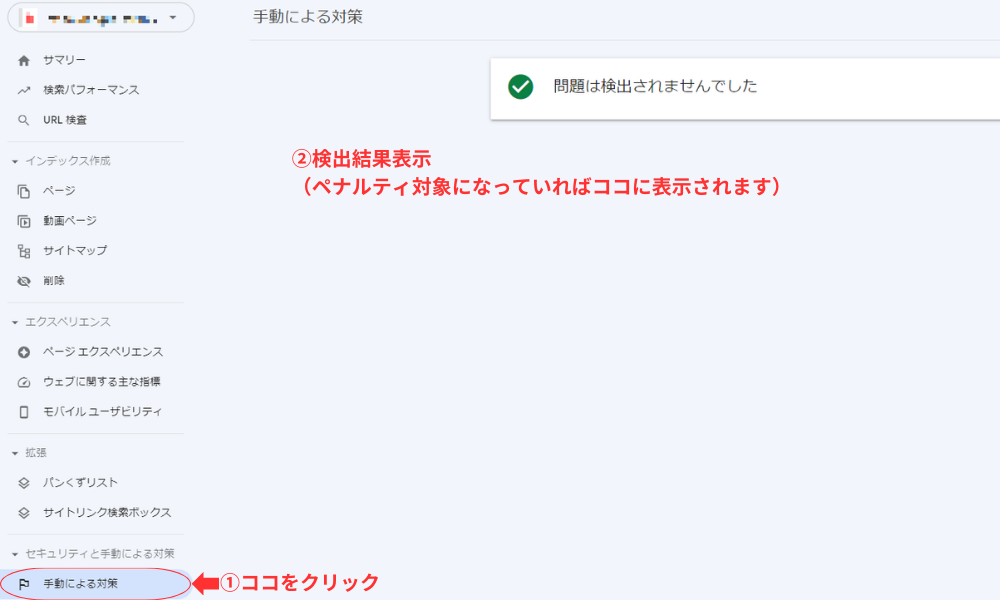

重複コンテンツはSEOペナルティになりますか?

重複コンテンツ自体は、SEOのペナルティにはなりません。

SEO対策を進めるなかで、意図せず重複コンテンツが発生することは頻繁にあります。多くのWebサイトで自然に発生するため、Googleがペナルティを課す可能性は低いと考えられます。

一方で、コピーコンテンツはGoogleのスパムポリシーに違反する行為であり、SEOペナルティの対象となります。

もし現在ペナルティを受けているか有無を確認したい際は、Search Console(サーチコンソール)を利用しましょう。

サーチコンソールにログインしたら、メニューから「セキュリティと手動による対策」を選び、その中の「手動による対策」を選びます。

「問題が検出されませんでした」と表示されたら問題ありません。

AIで作ると重複コンテンツになりますか?

AIを活用して作成したコンテンツをそのまま公開した場合、重複コンテンツになる可能性があります。

AIはWeb上の情報をもとに文章を生成するため、情報源となる他社のコンテンツと類似した表現や構成になり得るでしょう。特に、一般的なトピックについてAIが作成したコンテンツは、多くのサイトと似通ったものになりやすいです。

そのため、AIが作成した文章をそのまま掲載するのではなく、人間の手で編集を加えることが必要になります。

具体的には、AIが生成した文章に独自の体験談や事例を加えたり、最新の情報を反映させたりすることで、重複コンテンツの回避ができます。

robots.txtは重複コンテンツの回避に有効ですか?

robots.txtを使用して重複コンテンツを回避する方法は、適切ではありません。

robots.txtは、検索エンジンのクローラーに対して特定のページへのアクセスを制限するためのテキストファイルです。そのため、robots.txtでクローラーのアクセスを制限すると、検索エンジンはそのページの内容を読み取ることができなくなり、それが重複コンテンツであるかどうかを判断できなくなります。

robots.txtはクローラーを完全に制御するものではないため、設定していても検索エンジンが意図せずページを発見することがあります。つまり、robots.txtでクロールを制限したとしても、検索結果にURLが表示される可能性があるため、重複コンテンツの問題を解決することにはつながりません。

重複コンテンツは早めの対処・改善が大切

本記事では重複コンテンツについて、定義やSEOへの影響、回避の方法について解説しました。

重複コンテンツをそのままにしておくとSEO評価が分散し、クローラビリティも悪化してしまいます。canonicalタグや301リダイレクト、リライトを使って適切に回避していきましょう。

最後に、高品質なSEOコンテンツが作成できるツールをご紹介します。

EmmaToolsは、SEOに特化したAIライティングツールです。検索エンジンで上位表示している他社サイトを自動で分析し、コンテンツ内で使うべきキーワードと、その重要度を表示してくれます。

さらに、独自のアルゴリズムでコピー率チェックができるため、重複コンテンツを回避したライティングが可能です。

今後、質の高いコンテンツの作成に取り組んでいきたい方や、既存のコンテンツが上位表示せずにお悩みの方は、無料トライアルを実施しているので、ぜひチェックしてみてください。